논문명: unlearn what you want to forget efficient unlearning for llms

논문 링크: https://arxiv.org/abs/2310.20150

Unlearn What You Want to Forget: Efficient Unlearning for LLMs

Large language models (LLMs) have achieved significant progress from pre-training on and memorizing a wide range of textual data, however, this process might suffer from privacy issues and violations of data protection regulations. As a result, the ability

arxiv.org

핵심 정리만합니다

3줄 요약

- 기존 방법들로 Unlearning 하면 모델이 커서 부담된다.

- 거대모델답게 일부 파라미터만 써서 하자 (Adapter - Parameter Efficient Fine-Tuing)

- Loss 를 기가 막히게 설계해서 잊을 건 잊고, 기억할 건 제대로 기억하자

잊어야 한다는 마음으로

- ChatGPT 에 poem 이라는 단어를 반복해서 말하라고 했더니 개인정보를 뱉었다

- 이것만 봐도 데이터에 민감한 정보들이 함께 잠재되어 있었다는 걸 알 수 있다

- 아무리 뛰어난 전처리 기술이라도 예외가 있기 때문에 거대 언어 모델은 위험을 갖고 있다

- 특히 인종차별, 종교, 도덕, 범죄, 개인 정보 등 주의해야 할 사항들이 엄청나게 많은 이 시대에서 방대하면서도 건강한 데이터를 구축하는 일은 불가능에 가깝다

- 하지만 그렇다고 데이터를 다시 검수해서 처음부터 학습하는 일은 곤란하다. 천문학적인 비용이 드는 것은 물론이고, 성능이 재현된다는 보장이 없기 때문이다

(아래 상황은 현실과 무관하며, 제가 이해를 돕기 위해 만든 예시입니다)

ChatGPT를 개발했어. 그런데 ChatGPT 학습용 데이터 중 13군데에서 개인 정보가 있다는 걸 뒤늦게 알았어. 하지만 처음부터 ChatGPT 를 다시 학습하려고 하니, 26억이 들어. 심지어 다시 학습했다가 성능이 확 떨어지면 기존 고객들과 투자자들로부터 신뢰를 잃게 돼. 어떻게 하면 좋지?

- 이런 상황 속에서 사용할 수 있는 방법을 소개한다

Adapter Layer

- 왼쪽 그림은 Adapter 논문에서 발췌한 것인데, single linear layer 가 아니었다

- 아무튼 Transformer Layer 에 작은 파라미터를 추가해서 학습하는 방식이다

- 본 논문 기준, 실험에 쓰인 파라미터는 전체의 약 0.5% 라고 한다. 논문 제목에서도 거대 언어 모델을 위한 방법이라고 했으니, full-finetuning 없이 하는 방향을 제시했다는 점에서 의미를 가진다

손실 함수 설계

- xf: 잘못된 데이터

- xr: 전체 데이터 - 잘못된 데이터 = 남는 데이터

- F: 거대언어모델 파라미터

- f: 거대언어모델에 추가된 adapter layer 파라미터

- 대충 이 식의 의미는 잘못된 데이터는 기존과 아예 다른 분포를 갖고, 남은 데이터는 기존 분포를 최대한 유지해라는 것

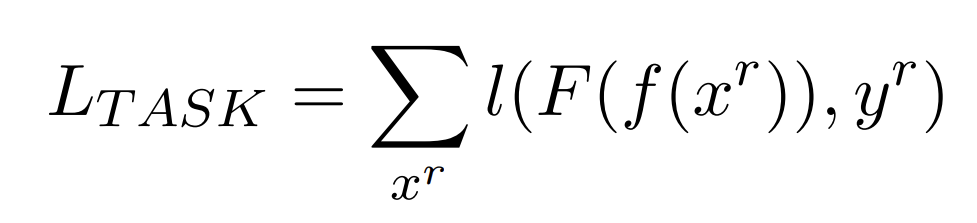

- 이건 원래 task 잘 하라고, 남은 데이터만 다시 넣어서 학습하는 거라고 한다

- 이건 pretraining 할 때 쓰인 손실함수라고 보면 된다. 저자도 본 논문에서 MLM loss 를 사용한다.

- 여기선 잊어야 할 데이터가 쓰이는데, 마지막 음수로 바꿨기 때문에 아예 반대로 학습해버려서 잊어버리라는 것 같다

- 이렇게 3가지 손실 함수를 모두 합친 게 본 논문의 주요 기여점이다

확실히 이렇게 하면, 실험 보면 알 수 있지만 잊어야 할 데이터만 잊고 기억해야 할 것들은 잘 기억하더라