논문명: Let's verify step by step

논문 링크: https://arxiv.org/abs/2305.20050

Let's Verify Step by Step

In recent years, large language models have greatly improved in their ability to perform complex multi-step reasoning. However, even state-of-the-art models still regularly produce logical mistakes. To train more reliable models, we can turn either to outc

arxiv.org

요약

- 언어 모델이 뛰어나지만, 아직도 논리적인 실수를 함

- 최근 강화학습 방식으로, 결과 감독(Outcome Supervision)과 과정 감독(Process Supervision)이 있는데 모두 중요함

- 수학 분야에서는 결과보다 과정을 감독하는 것이 성능에 더 도움을 줌

- 사용한 데이터셋도 공개함

개요

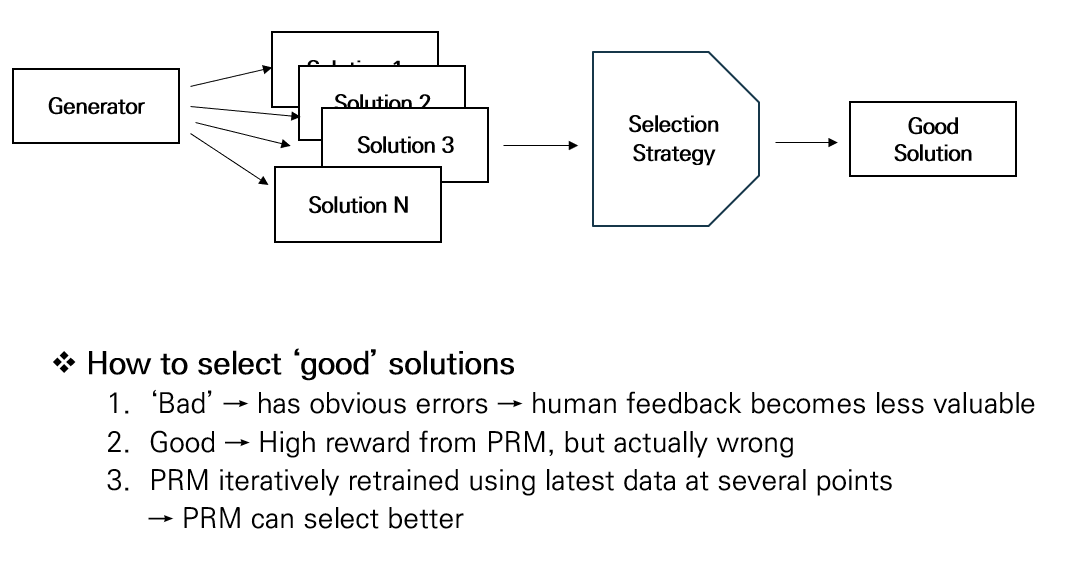

- 1. 수학문제를 generator 에게 제공한다.

- 2. generator 는 풀이를 생성한다.

- 그 풀이를 채점하는 것이 보상 모델의 역할이다.

- 이 논문의 핵심은 보상 모델이다.

- 3. PRM 은 과정 중심 채점, 즉 줄마다 채점한다.

- 4. ORM 은 결과 중심 채점, 즉 결과마다 채점한다.

- 채점은 0 과 1 을 분류하는 것을 의미한다.

Generator

- Generator 는 그냥 풀이를 생성해주는 모델로만 생각하자.

- 이 논문에서 핵심이 되지 않는다.

- 하지만 GPT4를 베이스라인으로 썼다고 하니, 신경이 안 쓰일 리가.

- finetuning 을 살짝 했는데, 풀이를 우리가 원하는 양식에 맞춰서 생성하기 위해서만 했다고 함.

데이터셋의 재료

- MATH dataset 을 사용하였음

- 어려운 문제들에 대한 풀이가 다 있어서 사용함

데이터셋 제작 과정

- 문제가 주어지면 generator가 다음과 같이 풀이를 만듦.

- 사람이 직접 라벨링함. 긍정, 중립, 부정으로 함.

- 중립은 애매함을 다루기 위해 만들었고, 테스트할 때는 긍정 혹은 부정으로 표기하도록 함.

- 이런 식으로 80만개의 데이터셋을 제작함.

풀이 선정 기준

- 아무 풀이나 쓰는 것보다는 좋은 풀이를 쓰는 게 좋음.

- 여기서 좋음이란, PRM 이 높은 보상을 줬으나 실제로 틀린 데이터를 의미함.

- 이게 좋다고 말하는 이유는, 명백히 틀렸으면 사람을 써서 데이터를 만드는 게 가치가 떨어지기 때문임.

- PRM은 계속 학습하면서, 더 좋은 풀이를 생성하려고 하며 PRM800K라는 데이터셋을 만드는 게 계속 기여함.

학습

- ORM은 사실 결과만 보면 되기 때문에 채점은 마지막에 달린 정답이 맞았는지로만 함.

- 이 경우, 풀이는 틀렸고 답만 맞은 경우(false positive)도 인정하기 때문에 조심하긴 해야 함.

- PRM은 풀이를 한번에 넣으면, 매 줄마다 정답인지 아닌지 예측해줌.

- ORM 의 경우엔, wrong answer solution 만 보는 것은 편향된다고 판단하여 추가적으로 generator로부터 학습함.

- (사실 이런 식으로 정밀하게 비교하기 어렵거나, 생소해서 이해가 어려운 부분이 많습니다.)

실험 결과

- 사실 여기서 논문 읽는 걸 포기했다.

- N 이 무엇을 의미하는지도 정확히 와닿지 않고, 이 실험의 의미도 애매하다.

- 실험 자체가 training set 이 달라서 비교도 어렵다.

- 물론 이걸 해결하려고 뒷부분에 다른 실험을 한다.

- 하지만 그 부분들도 이해가 안 간다.

솔직히 내 실력이 부족했기 때문이지만, 그러기엔 이 논문은 이해도 어렵고 시사하는 바가 명확하지 않다. 논문이 이렇게 주저리 주저리 이야기하는 경우도 처음 봤다. openAI라고 해서 기대하고 열었으나, 부응하지 못했던.

요약까지만 읽고 가져가는 게 맞는 것 같다.

'NLP > 논문이해' 카테고리의 다른 글

| [논문이해] LARGER LANGUAGE MODELS DO IN-CONTEXT LEARNING DIFFERENTLY (0) | 2023.07.13 |

|---|---|

| [논문이해] A Survey on In-context Learning (0) | 2023.07.10 |

| [논문이해] Less is More: CLIPBERT for Video-and-Language Learning via Sparse Sampling (0) | 2023.02.24 |

| [논문이해] CLIP4Clip: An Empirical Study of CLIP for End to End Video Clip Retrieval (0) | 2023.01.27 |

| [논문이해] locally typical sampling (1) | 2023.01.17 |